Az első csatát az igazságért vívjuk a mesterséges intelligenciával, és vesztésre állunk

A Google néhány régióban már bevezette azt a keresős megoldását, hogy az első találat egy mesterséges intelligencia (MI) által összekapart válasz. Ezért ha valaki arra kíváncsi, hogy miért nem működik az index az autóján, akkor például megtudhatja, hogy ki kéne cserélnie az amúgy nem létező indexfolyadékot, vagy azt, hogy ha azt szeretné, hogy ne csússzon le a sajt a pizzájáról, akkor rakjon bele egy kis ragasztót. Vagy, ahogy a 404 Media írta a címében:

„A Google 60 millió dollárt fizet a Redditnek, hogy Fucksmith azt mondja a felhasználóinak, hogy egyenek ragasztót.”

Ez elsőre egész vicces, főleg ha az ember tudja, hogy geológusok valójában nem javasolják, hogy mindenki egyen meg naponta egy kavicsot, vagy azt, hogy 38,8 fok nem elég, hogy megsüljön a csirkemell. Egyrészt a Google – egyelőre – egyértelműen jelzi, hogy ez egy MI-generált válasz, másrészt olyan kis béna, hogy ha az ember csak egy kicsit figyelte az elmúlt évek technológiai fejleményeit, akkor azonnal látja, hogy ezt MI rakta össze.

Van azonban három probléma. Egyrészt, amit a Google csinál, rendkívül káros a sajtóra és az emberek médiába vetett bizalmára nézve. Másrészt, nem szabad azt feltételezni, hogy mindenki pontosan tudja, mi fán teremnek a nagy nyelvi modellek és MI-csipek. Harmadrészt, ma már egyáltalán nem mindig ilyen könnyű kiszúrni, ha MI kalapál össze valamit.

Kezdjük azzal, amivel valószínűleg a legtöbben találkoznak az interneten: az MI-generált képekkel. Amikor először megjelentek, még egész viccesek voltak, ugyanis sok, nagyon látványos gyerekbetegségük volt. Vegyük például azt a képet, ami tavaly a törökországi földrengéskor megihlette Gyurcsány Ferencet:

Ezen a képen látható a legtöbb olyan hiba, amiből ma még többnyire ki lehet szúrni, hogy egy kamuképről van szó. Kezdjük azzal, hogy nehéz eldönteni, hogy egy festményt látunk-e, vagy egy fényképet. A vonalak valahogy túl elmosódottak, de közben vannak nagyon éles részletek, nem egészen egyértelmű, hogy hol is van a fókusz.

„Árulkodó jel lehet például a fényesebb bőr (AI sheen), az eltorzult vonások, vagy ha videónál a szöveg, a mimika és a gesztikuláció nincsenek összhangban, esetleg amikor hosszabb videós felvételen megjelennek oda nem illő, akár a fizika törvényeinek ellentmondó jelenetek, mozzanatok”

– mondta Horváth Imola, a Hiflylabs fejlettanalitika-csapatának vezetője. Ez a videós hiba például gyakran kiszúrható Bíró Ada, a köztévé MI-vel létrehozott műsorvezetőjének szerepléseinél.

Na, de vissza a földrengéses képhez. Nézzük meg a sisakot: az a lehajtható arcvédő száz százalék, hogy valójában nem lehajtható, mert beleolvad a sisakba. A készítőnek egyébként jár a piros pont, amiért rányomta az E.M.A.K rövidítést, ami valóban a görög katasztrófavédelmet takarja, bár általában pontok nélkül írják. Ha egy kicsit jobban megnézzük, a tűzoltó füle sem az igazi, több árok van benne, mint amennyi egy igazi embernél előfordul, és a sisak pántja is furcsa kicsit, de csak ennyiből talán nem mindenkinek tűnik fel, hogy a kép nem igazi.

Ha arcokat látunk, akkor például a fogak nagyon jó indikátorai lehetnek annak, hogy egy képet MI gyártott, ugyanis nem mindig tudja eltalálni, hánynak is kéne egyszerre beférnie egy ember szájába. Néha a hajból is meg lehet állapítani ugyanezt, például ha egy tincs félúton megszakad, majd néhány centivel lejjebb folytatódik, vagy hasonló trükkökkel röhögi arcon a fizika törvényeit. Ez a képen látható gyereknél nem figyelhető meg, viszont az elmosódottság nagyon látványos.

Ezeken túl a feliratokkal is le lehet buktatni az MI-t. Ha a parancsot adó felhasználó nem eléggé alapos, akkor a rendszer gyakran csak egy elmosódott krikszkrakszot dob ki, ahogy ezen a képen is látható a tűzoltó felvarróján. Ez egyébként egész szép munka, majdnem eltalálták a görög tűzoltóság logóját. Ahhoz már szükség van egy kis háttértudásra, hogy az ember kiszúrja, hogy csak egy sárga csík szokott lenni ezeken a kabátokon, a könyök környékén.

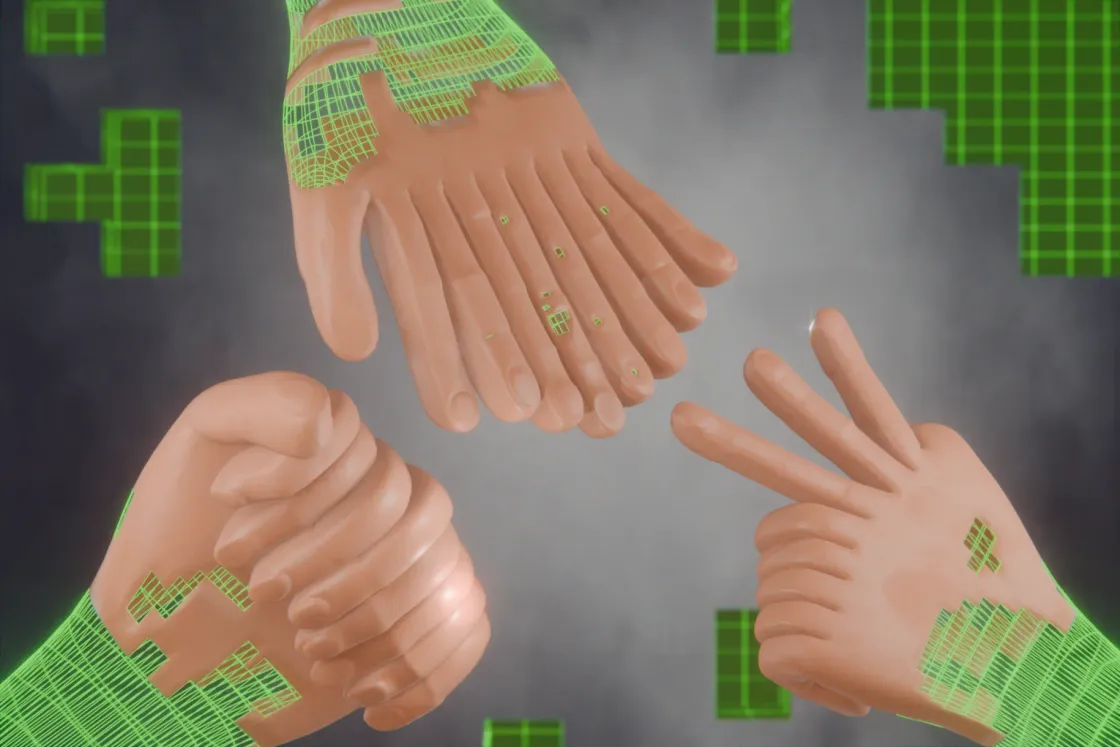

A képen még két dolog van, amiből ki lehet szúrni, hogy valószínűleg nem igazi. Az első talán a legerősebb fegyverünk az MI-gyártotta képek elleni harcban: meg kell nézni, hogy hány ujjuk van az embereknek, és azok hogy állnak. Szegény tűzoltónak legalább hat ujja van a jobb kezén, a bal pedig felfoghatatlan pozitúrában áll, mintha teljesen visszahajlana az alkarjához.

A másik fegyverünk a teljes kép értelmezése. Ha elsőre nem tűnik is kamunak, érdemes végiggondolni, hogy mit is látunk rajta. Mekkora szerencse kell ahhoz, hogy egy görög zászlóval díszített sisakú tűzoltó a földrengés után pont egy olyan gyereket találjon, akinek por fedi az arcát, de a pólója épp annyira frissen mosott, hogy tökéletesen látszik rajta a török zászló? Itt egy kis extraként beugorhat a történelmileg alapvetően nem túl baráti viszony a két ország között, ami tovább mélyítené egy ilyen fénykép jelentőségét. Ennek máris meg kellene kongatnia egy kis vészharangot az ember fejében, és ehhez érdemes hozzánézni a fent írt többi apróságot. Szerintem kezdje a kezekkel.

Persze itt nem arról van szó, hogy Gyurcsányt ne ihlethetné meg egy ilyen kép, csak illene helyén kezelnie azt, és érdemes lenne jeleznie, hogy ez egy MI által generált kép. A politikus azonban egyrészt kritika nélkül vette át a képet, de ami talán még kevésbé elegáns, hogy forrásmegjelölés nélkül. Ugyanis a – jobb szó híján – eredetit a görög tűzoltóság nyugalmazott vezérőrnagya, Panagiotisz Kotridisz készíttette a Photoshop és a Midjurney segítségével, a bajtársai tiszteletére. Az már másik kérdés, hogy mivel tanították be ezeket a szoftvereket, ahogy az is, hogy milyen szürkésfekete zóna az MI-generált képek jogi helyzete.

Nézzünk még néhány további klasszikus példát! A hatujjú, pont palesztin zászlós pulcsit viselő kisfiú:

Elliot Higgins, a Bellingcat oknyomozó oldal kreatív igazgatójának MI-s kreálmányai Donald Trumpról, ami miatt a Midjourney letiltotta. Ezeken is sok, már említett jellegzetesség megtalálható, például az elmosódott szövegek és a belőhetetlen fókusz:

Ezt Donald Trump osztotta meg a saját közösségi oldalán, a Truth Socialön. A puha gumiként gyűrődő cipő, a fura fények és azok a fránya ujjak lebuktatták:

Az egyszerre fotorealisztikus és festményszerű arcú Ferenc pápa, aki a kép tanúsága szerint pufidzsekiben fotózkodott, míg a valóságban egészségi problémákkal küszködik:

Egyre kevésbé ilyen egyszerű

Az a baj, hogy csak az elmúlt egy-két évben olyan sokat fejlődött a technológia, hogy, bár többnyire még ma is relevánsak, egyre kevésbé működnek az említett MI-kiszúró praktikák.

A ChatGPT-t is fejlesztő OpenAI idén év elején bemutatott Sora szöveges utasításokból csinál videókat, és egészen lenyűgöző, amit kidob magából. Ha az ember nem képkockáról képkockára elemzi, hanem ne adj’ isten egyben élvezi a videókat, talán nem is tűnik fel neki,

- hogy egy kicsit túl simán, csúszósan halad az egész;

- hogy a buszok a videó elején túlságosan szinkronban haladnak;

- hogy a cseresznyefa ritkán virágzik a tél közepén, és a virágai ritkán lebegnek a levegőben;

- hogy a perspektíva furán változik;

- hogy a piros kabátos alak átsétált egy térdmagasságú korláton:

Ezek a videók egészen olyanok, mint ha igaziak lennének (persze ha nem vesszük figyelembe, hogy mamutok sajnos nem ügetnek már a Földön, és az űrhajósok sem kötött sisakban indulnak küldetésre).

Ezzel szemben ott van a TCL saját gyártású, teljesen MI-generált romkomja, ami minden szempontból borzalmasan néz ki, és tökéletesen illusztrálja, miért sztrájkoltak a hollywoodi előadóművészek és forgatókönyvírók:

Minden képkocka olyan, mintha a 80 fokos aszfalt felett vették volna fel, minden tereptárgy, minden ember, minden vonás megállás nélkül hullámzik és a szemünk előtt alakul át. Nem animáció, nem is élő szereplős, valahogy minden rossznak tűnik. A női főszereplő annyit változik, hogy valójában legalább három különböző nőként jelenik meg, a jegygyűrű csak egy gyémánt, sok képen nem sikerült valósághűre redukálni az ujjak számát, és az egyik motor egy vágással elhagyja mindkét indexét. De a legjobb az óra:

Mindenki nézze meg a videót, tényleg nagyon jó! Na de a TLC nagy betűkkel jelzi, hogy ez az egész MI, tehát aki nem akar ilyet nézni vagy támogatni, el tudja kerülni. De ahogy például a Gyurcsány által is továbbosztott kép alapján láthatjuk, ez nem mindig ilyen egyértelmű, és a videók egyre inkább a Sora által gyártottakra fognak hasonlítani, mint a párizsi lidércnyomásra.

„Nemrég voltam egy konferencián, ahol a közönségnek szavaznia kellett, hogy az öt képből melyik az, ami MI által generált. A végén kiderült, hogy mindegyik az volt, és eléggé megosztotta a közönséget, kb. csak egy-kettőnél volt az, hogy a túlnyomó többség jelentkezett, a többiről nem is feltételezték. Tehát már egyre jobb minőségűek, egyre nehezebb ezeket felismerni, főleg, ha nem tudatosan keresi az ember ezeket a jeleket”

– mondta Horváth.

Hozzátette, hogy a generálás egyáltalán nem determinisztikus, azaz előfordulhat, hogy egy promptra (ez a felhasználó által megadott szöveges parancssor, ami alapján az MI dolgozik) kaphatunk egy szürrealista alkotást vagy akár egy teljesen fotorealisztikus képet is. A technológia mostanra egyre hatékonyabb, így egyre könnyebb az utóbbit előállítani. Ma már elég egy fénykép és néhány elkapott mondat ahhoz, hogy ellopják valakinek a személyiségét és deepfake-et gyártsanak belőle, ahogy egy ukrán youtuberrel is történt.

„Azt lehet majd összevetni, hogy egy normál interjúban Taylor Swift hogyan beszél, milyen stílusban, milyen hanghordozással, milyen a mimikája, szemben az MI által generált videóban, videóklipben látottal. Ezeket lehet elemezni, de itt is fennáll az, hogy hosszú távon ezek egyre jobbak, egyre életszerűbbek lesznek, egyre nehezebb lesz ilyen egyszerű statisztikai hasonlósági metrikák alapján megmondani, hogy akkor ez most valós vagy nem valós” – mondta Horváth.

A szoftveresen generált hanganyagokkal még nehezebb a helyzet. Ezek már régóta velünk vannak, elég csak a GPS-hangokra, Sirire, Alexára, Cortanára (RIP) vagy újabban Bíró Adára gondolni. Ezek már mind egész természetesnek hangzanak, és ha az OpenAI vagy a Google bemutatójából indulunk ki, akkor egyre jobbak lesznek, és szabad füllel nem nagyon lehet majd kiszúrni, hogy nem embereket hallunk.

„Az alapprobléma az, hogy amikor betanítasz egy modellt akár detekcióra, akár generálásra, akármilyen feladatra, az statikus lesz, azt tudja, amivel megtanítottad és megetetted. De hogyha én fogok egy nyílt forráskódú, hanggenerálásra való modellt, és finomhangolom máshogy, mint amilyenek az eddigi létező generáló modellek, az már a detektornak nem fog fennakadni a szűrőjén.”

Ez egy kicsit olyan 22-es csapdája, mint az a macska-egér játék, amit a kiberbűnözők vívnak a kiberrendészekkel, akik sok esetben nem tudnak mást tenni, mint hogy reagálnak, mondjuk, egy kémszoftver nyújtotta fenyegetésre, miközben a hekkerek már a következő támadáson dolgozhatnak.

Végül ott az írott szöveg, ami valószínűleg a leggyakrabban használt MI-s készség. Van, aki keresőként használja a ChatGPT-t, más önéletrajzot, motivációs levelet gyártat vele, de olyan is akad, aki kódot írat az MI-vel, vagy átnézeti vele a saját kódját, hogy mi lehet vele a baj. Az egyetemek és az iskolák egyelőre nem nagyon tudnak mit kezdeni például az MI által írt dolgozatokkal, amit a diákok már ki is használnak.

Persze már régóta léteznek plágiumszűrő szoftverek, mint például a Turnitin, de ezek egyelőre nem tudják százszázalékos pontossággal kiszűrni az MI-generálta szövegeket. Sokfajta modell van, ezeket más-más módon tanítják be, emiatt különböző stílusjegyek és típushibák jönnek ki a generált tartalmakon. Amiatt is nehéz vagy inkább lehetetlen egy száz százalékban pontos ellenőrző programot fejleszteni, mert ha hetente adnak ki új verziót ezekből a nagy nyelvi modellekből, amikre az MI-szolgáltatások épülnek, akkor igen nehéz ezekre kellően gyorsan reagálni. Horváth szerint ahogy a képeknél, ezeknél is van mire figyelni, ilyen

- a szöveg stílusa: az MI, ha nem kap más utasítást, gyakran nagyon egysíkúan ír, és alapvetően hasonló hosszúságú mondatokat alkot. Ez egy ember által írt szövegnél ritkán van így;

- a preferált szóhasználat: ez modellenként eltérő lehet, de egy-egy modellnek megvan a maga jellemzője. Ez a tanulás során beszívott anyagokon és a felhasználói visszajelzéseken is múlik, de alapvetően egy matematikai átlagolás, statisztika eredménye;

- az alignmentből, azaz az MI viselkedési beállításából fakadó megjegyzések a generált szövegben: például ha kitér arra, hogy egy adott témának milyen etikai vonatkozásai lehetnek.

Tényleg nincs remény?

Az internet egyik nagy ígérete az volt, hogy gyakorlatilag az emberiség teljes tudását egykattintásnyi távolságba hozza. Ez részben így is történt, de közben eszméletlen mennyiségű hazugság is megjelent a világhálón. Ezek mögött többfajta szándék is húzódhat: választópolgárok befolyásolása, lájkgyűjtés, szimpátiakuncsorgás és persze a pénzszerzés. Már vannak influenszerek, akik azt tanítják (pénzért), hogy hogyan lehet MI-vel gyártatni videókat közösségi oldalakra, amikkel aztán rengeteg pénzt lehet bezsebelni. Ez gyakorlatilag szemét, amit botok néznek, és emiatt becsorog néhány hirdetési dollár.

Bár már Petőfi Sándor is megmondta, hogy nem minden igaz, ami az interneten van, azért hajlamosak vagyunk hinni annak, amit, mondjuk, a Wikipédián olvasunk. Természetesen érdemes mindenhez némi egészséges szkepticizmussal hozzáállni, de azért viszonylag nagy bizalommal fordulunk a nethez.

Nem minden MI-generált tartalom rosszindulatú. A földrengéses-tűzoltós kép például alapvetően jó szándékból készült. Viszont nagyon sok MI által generált tartalommal nem ez a helyzet, hanem álhírek terjesztéséhez használják fel ezeket, valamint bizalmatlanságot ébresztenek velük az amúgy hiteles forrásokkal szemben.

Arról nem is beszélve, hogy az elmúlt évek szórakoztatóipari vállalati döntései alapján a kreatív szakmákban dolgozók jó okkal félthetik a munkájukat. Ezt gondolom, nemcsak leírni lehangoló, hanem valószínűleg olvasni is, úgyhogy lássuk, van-e valamilyen megoldás! A jó hír az, hogy van, de nem könnyű. A felelősség valószínűleg átkerül majd azokra, akik úgymond kézművesen gyártanak tartalmakat. Jó, ha dokumentálva van a munkafolyamat, a felhasznált anyagok, a verzióelőzmények, mert ezekkel bizonyítani lehet, hogy valamit tényleg az alkotott meg, aki állítja.

A Google nyílt forráskódúvá teszi ugyan a Synth ID nevű vízjeles megoldását, amivel a saját rendszereikkel gyártott kép- és hanganyagokat jelölik meg, de Horváth szerint elképzelhető, hogy idővel a valós ember által előállított tartalmakba is kell majd vízjel. Ennek két oka lehet: egyrészt ebből kevesebb lesz, hiszen jó munkához sok idő kell, másrészt ha valaki például egy hírességről csináltat deepfake pornót egy MI-vel, akkor valószínűleg nem akarja, hogy vízjel kerüljön a képére, videójára, és mindent meg fog tenni, hogy ezt elkerülje. Rövidebben: azokat könnyebb szabályozni, akik alapvetően nem akarnak törvényt sérteni.

Ettől függetlenül valószínűleg minden nagy gyártó büszkélkedni fog azzal, hogy van valamilyen vízjeles rendszerük. A Google-nek, a Thomson Reuters Intézetnek, a Truepicnek és a New York Timesnak is vannak már olyan hitelesítő rendszerei, amikkel képek eredetiségét, eredetét vizsgálják, és ez egyébként valóban nagyon fontos és hasznos, de a már említett probléma: ezek közel sem tökéletesek.

Az átlagemberek rendelkezésére azonban egyelőre ugyanaz az eszköz áll, ami az álhírek felismerésénél: a józan esze. Ha figyelmesen jár-kel az interneten, és felismeri a felsorolt jellegzetességeket, akkor jó eséllyel kiszúrja majd az MI által generált tartalmakat – legalábbis egyelőre.

Azt azonban nem lehet tudni, hogy egy év múlva milyen szinten lesz a generatív MI. Előfordulhat, hogy akkor már meg tud birkózni azzal, hogy az embereknek általában legfeljebb tíz ujjuk van. És ha ezt az akadályt leküzdi, akkor ki tudja, hol a határ, és így egyre nehezebb lesz kiszúrni ezen a csodás interneten, hogy mi igaz, és mi az, amit csak egy robot álmodott meg.