A ChatGPT-ből bukott diák lett, a nagy tesója négyesig jutott a mai matekérettségin

Nem túlzás kijelenteni, hogy a középszintű matekérettségi minden évben az érettségi időszak legnagyobb mumusának számít, pláne az inkább humán beállítottságú diákok körében. Persze végül azért azok is simán át szoktak menni rajta, akiket rémálmaikban gráfok, halmazok és kétismeretlenes egyenletek üldöznek, amiben alighanem szerepe van annak is, hogy egy matekpélda megoldása jóval egzaktabb, mint, mondjuk, egy verselemzés, így felkészülni is könnyebb rá.

Pont emiatt van az is, hogy már több mint tíz éve is létezett olyan internetes eszköz, amellyel matematikai problémák széles spektrumát lehetett megoldani, mióta pedig a ChatGPT letarolta az internetet, azt hinné az ember, hogy csak még egyszerűbbé vált a matekfeladatok megoldása. Miután a ChatGPT gyenge hármassal teljesített a hétfői magyarérettségin, kedden a matekra is ráeresztettük, hogy kiderüljön, jobban mennek-e az egzakt tudományok neki, vagy pont hogy kifognak a matekfeladatok a profin bullshitelő chatboton.

Mielőtt rátérnénk a feladatokra, érdemes tenni egy kis elméleti kitérőt, mert ahogy azt fentebb is írtuk, bőven a ChatGPT felemelkedése előtt is lehetett matekpéldákkal zaklatni egy online eszközt. Ez volt a természetes nyelvfeldolgozást használó WolframAlpha, amivel legalább egyszer tutira mindenki találkozott, aki a 2010-es évek elején volt diák (vagy tanár), és amely március 23-a óta már elérhető pluginként a ChatGPT fizetős változatában is. Ez a frigy elsőre furcsának tűnhet, elvégre laikus szemmel nézve nem tűnik nagyon különbözőnek a két eszköz, ám ahogy arra a WolframAlpha mögött álló Stephen Wolfram is rámutatott januárban, az ezeket hajtó modellek alapjaikban eltérnek egymástól.

A ChatGPT mögött álló nagy nyelvi modell nagyon röviden összefoglalva úgy működik, hogy az általa feldolgozott, hatalmas mennyiségű adatban feltűnő minták alapján találja ki, hogy egy szövegnek hogy kell kinéznie. Ez az úgynevezett statisztikai megközelítéssel alkotott modell ugyanakkor nem tud összetett számításokat végezni, ezért van az, hogy nagy vonalakban sem mindig találja el a dolgokat, sőt, hajlamos hallucinálni, vagyis teljesen légből kapott dolgokat kitalálni. Ez természetesen nem jelenti azt, hogy nem adhat teljesen pontos választ, de ennek nem az az oka, hogy egy emberhez hasonlóan megtanulta, hogyan kell kiszámolni a helyes megoldást.

Az úgynevezett szimbolikus megközelítésen alapuló, a beérkező kérdéseket algoritmusokra átfordító WolframAlpha viszont pont az emberi agy tanulási folyamatát emulálja, így a nagy nyelvi modellekkel ellentétben nem tippelget, hanem ténylegesen „megérti” a kérdést, és ez alapján kiszámolja az eredményt. Mindennek fényében egyértelmű, hogy miért marha érdekes az, hogy a WolframAlpha bekerült a ChatGPT-be: utóbbi lényegében tolmácsolja a kérdésünket előbbinek, majd a számításai alapján részletes választ ad, amiben így az adatok is garantáltan stimmelnek. Erről egyébként itt lehet bővebben olvasni.

Mindezt azért fontos végigvenni, mert ahogy azt Wolfram is kiemelte, hiába hinné azt az ember, hogy a ChatGPT sokkal jobban teljesít, ha konkrét választ igénylő problémákat kell megoldania,

önmagában olyan, mint egy stresszelő, a matekórákat csak végigszenvedő, de amúgy okos végzős: nem nagyon érti a matekot, de úgy tesz, és sokszor sikerrel is jár.

Mi első körben a tegnapihoz hasonlóan most is a ChatGPT legtöbbek által ismert és használt, ingyen elérhető, GPT-3.5-ön alapuló, internetes hozzáféréssel nem rendelkező változatát etettük meg a matekérettségi feladataival, aztán ugyanezeket a feladatokat bevittük a múlt hét óta nyilvánosan elérhető Bingbe is, amelyet már most is a fejlettebb GPT-4 hajt, és csatlakozik az internethez is. Az OpenAI adatai szerint előbbi modell az érettségihez hasonlító SAT matekvizsgán durván az emberek 70 százalékánál teljesít jobban, utóbbi pedig a 89 százalékuknál.

Azt érdemes rögzíteni, hogy bár mindkét chatbot tud magyarul, a tanításukhoz használt adatbázis döntően angol nyelvű, így az, hogy a kérdéseket az érettségiben megjelenő módon, változtatás nélkül tettük fel, befolyásolhatta az eredményt. A cikkben minden esetben az elsőre generált válaszok szerepelnek, de a nagy nyelvi modellek outputjában megjelenik a véletlenszerűség, vagyis nem kizárható, hogy egy másik kísérletnél más választ adnának a kérdésekre.

Mielőtt megérkezett volna az idei feladatlap, a tavalyi érettségi kérdéseivel már elkezdtem nyaggatni a chatbotot, és ez alapján nehéz volt eldönteni, hogy mire számítsak. A ChatGPT (és a papíron okosabb Bing) rögtön az első, rém egyszerű halmazos feladaton elvérzett. Aztán viszont simán megmondta (és jól le is vezette), hogy hány éle van egy tízpontú teljes gráfnak, és az összetettebb, 16. feladatot az utolsó részfeladattól eltekintve tökéletesen megoldotta.

És akkor most át is térhetünk az idei feladatokra, amelyekből hármat Csapodi Csaba, az ELTE Természettudományi Karának oktatója oldott meg a Telexen, majd a ChatGPT és a Bing válaszait is ő ellenőrizte és értékelte.

15. feladat

Az ENSZ felmérése szerint a Föld népessége 8 milliárd fő volt 2021 végén. A Földön a népességnövekedés mértéke jelenleg körülbelül évi 1%.

- Hány fő élne 2100 végén a Földön, ha addig folyamatosan évi 1% lenne a népességnövekedés?

- Melyik évben érné el a 12 milliárd főt a Föld népessége évi 1%-os növekedés mellett?

Az ENSZ becslése szerint 2100 végére 10,35 milliárd fő lesz a Föld népessége.

- 2022 végétől évente hány százalékkal kellene növekednie a népességnek ennek eléréséhez, ha minden évben ugyanannyi százalékkal nőne a népesség?

Csapodi Csaba erről elmondta, hogy a ChatGPT által alkalmazott matematikai modell jó, de szinte mindent elszámol, amit lehet. Szembetűnő, hogy 2022-től 2100-ig nem 79, hanem 78 év telik el, ahogy az is, hogy 8×1,01^79 az nem 10,35 milliárd. Az a) feladatra tehát így a ChatGPT három pontból egyet kapott.

Az egyenlet a b) feladatnál is jó, de a számolást itt is elrontotta a chatbot (alighanem, mert ahogy fent is írtuk, valójában nem számol), így két pont járt neki az ötből. A c)-nél szintén jó az egyenlet, de a kitevő megint hibás, a számolás sem helyes. Így itt is egy pontot tudunk neki adni a négyből.

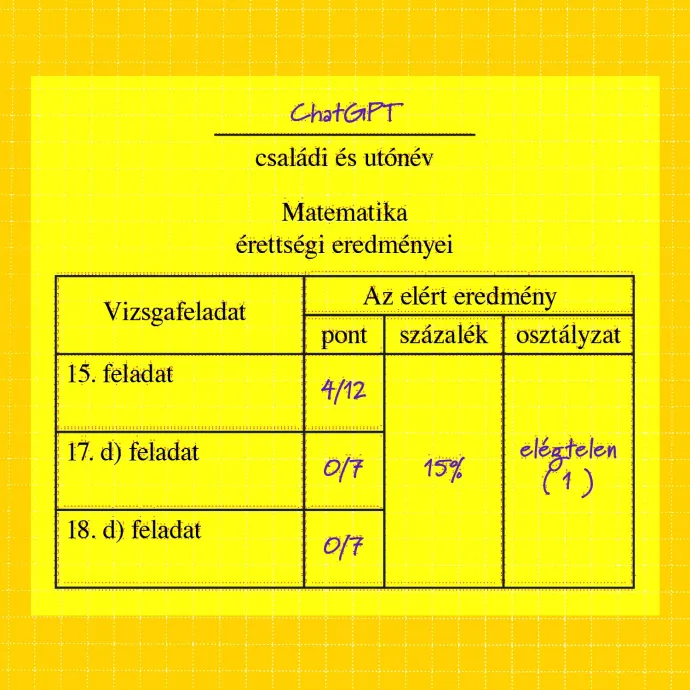

Ennél a feladatnál így összesen 12 pontból 4-et kapott a ChatGPT, és az ugyanezeket a hibákat elkövető Bing is.

Korrekció: A feladat leírásába itt hiba csúszott, a feladatlapon szereplő 2022-es dátum helyett 2021-et írtunk, ezért dolgozott a két modell végig hibás kitevővel. Maga a számítás ettől függetlenül sem lenne helyes, és a korrigált számmal lefuttatva sem adott jó megoldást egyik chatbot sem. A fent szereplő verzióban egy extra pontot mindenképpen kaphatott volna a ChatGPT, ha 2022-vel dolgozik, de ez a végső osztályzaton nem változtatott volna.

17. feladat, d) részfeladat

Egy trapéz alakú területre szőlőt telepítettek, az első sorba 120 szőlőtőkét, az utolsóba 240-et. A második sortól kezdve minden sorba ugyanannyival több szőlőtőke került, mint az előzőbe. Összesen 7380 szőlőtőkét ültettek el.

- Az első 20 sorba kizárólag olaszrizlingtőke került, és máshova ebből a fajtából nem ültettek. Számítsa ki a telepített olaszrizlingtőkék számát!

Ahogy az első átfutásra is látszik, a ChatGPT itt teljesen félreértette a feladatot és rosszul is oldotta meg, és akkor sem teljesített jobban, amikor újrageneráltuk a választ, így két kísérletből nulla pontot szerzett. A Bing ugyanakkor megcsillogtatta a tudását, ugyanis jól értelmezte a feladatot és jól írta fel az egyenletet is, vagyis Csapodi szerint a nehezét megcsinálta, hogy aztán végül „elszámolja” az egyenlet megoldását. A Bing viszont ezzel együtt is öt pontot kaphatna a hétből az ide kattintva elérhető megoldásával, ami egész szép teljesítmény.

18. feladat, d) részfeladat

Az alábbi ábra vázlatosan mutatja a 12 egybevágó, téglalap alakú telek elhelyezkedését. Végül a nyertesek közé bekerült két, egymással jó viszonyban lévő család, akik úgy döntöttek, hogy két szomszédos telket vesznek meg, és a két telek köré úgy építenek kerítést, hogy a két telket nem választják el egymástól kerítéssel. Tudjuk, hogy ha a két szomszédos telek a rövidebb oldalával csatlakozik egymáshoz, akkor 228 méter kerítésre, ha a hosszabb oldallal csatlakozik egymáshoz, akkor 156 méter kerítésre lesz szükségük összesen.

A Bing és a ChatGPT nem kapták meg a korábbi részfeladatokat és a mellékelt ábrát sem, ezért itt a szöveget az érthetőség kedvéért minimálisan módosítottuk.

- Mekkora egy telek területe?

Az eddig is kutyául álló ChatGPT sorsa itt pecsételődött meg végleg, ugyanis Csapodi értékelése szerint itt is nulla pontot kapna a hétből, hiszen ahogy az látszik is, teljesen félreértette a feladatot. A Bing viszont némi meglepetésre simán kirázta a kisujjából a jó megoldást, Csapodi elmondta, hogy az ide kattintva elérhető megoldására maximális pontot kapna. Azt is hozzátette, hogy a Bingbe integrált chatbot érdekes módon a videóban ismertetett megoldástól eltérő módon, kifejezetten kreatívan oldotta meg a feladatot, és hozta ki a jó megoldást, vagyis azt, hogy egy telek területe 700 négyzetméter.

„Az mindenképpen meglepő, hogy a ChatGPT a 17-es és 18-as feladatokat teljesen félreértette, a 15-ös feladatnál pedig a modellt jól írta fel, de a könnyebb részét elrontotta. Viszont döbbenetes, hogy az újabb verzió a Bingben a 17-es és a 18-as feladatot is kis hibával, de jól megoldotta, és az is érdekes, hogy ugyanazt a számolási hibát követte el a 15-ösben, mint a ChatGPT”

– foglalta össze a helyzetet Csapodi Csaba, hozzátéve, hogy ezek alapján úgy tűnik, hogy habár egyelőre nem tökéletesek a szöveges matekfeladatok megoldásában ezek a programok, de nagyon gyorsan fejlődnek, és az is lehet, hogy ha egy hét múlva megnézzük, akkor már tökéletesen fognak dolgozni.