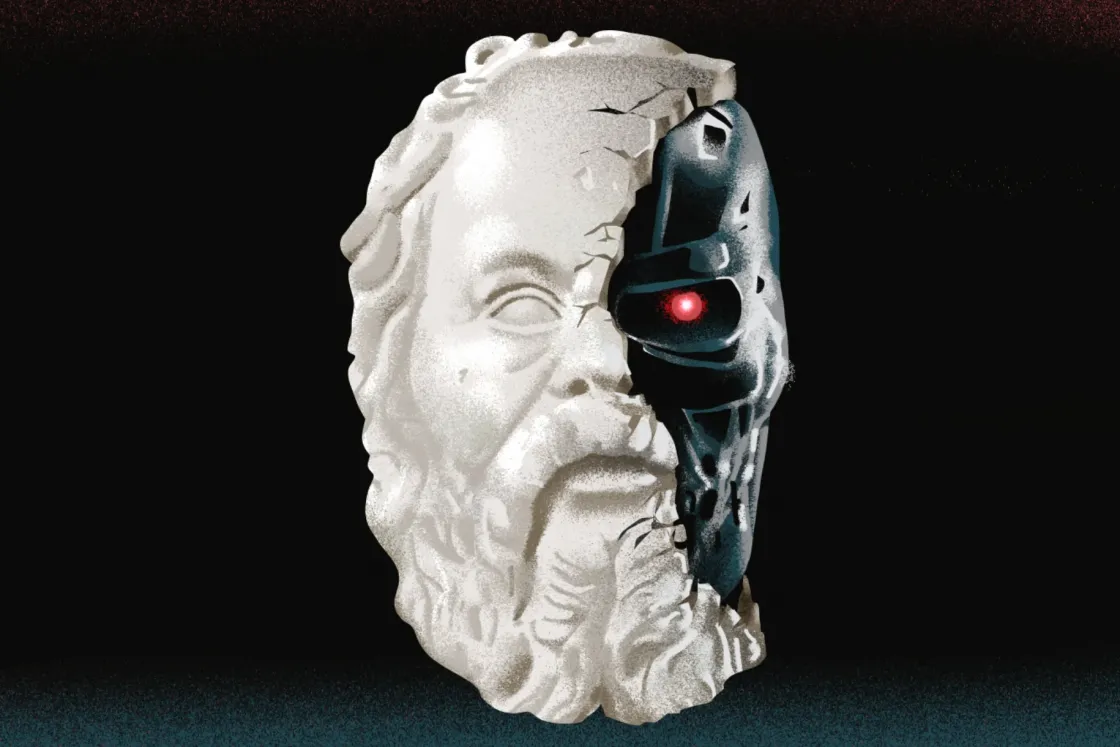

Szöveget ír, művészkedik és a létezéséről filozofál a mesterséges intelligencia, de ez még mindig nem a Skynet hajnala

A mémek az internet felemelkedése óta fontos szerepet töltenek be az online kultúrában, és lehetővé teszik, hogy humoros formában kommunikáljunk egymással, és osszuk meg az ötleteinket. A mesterséges intelligencia megjelenésével még népszerűbbek lettek, az MI által generált tartalmakból gyakran csinálnak mémeket, szöveges, videós és képi formátumban is. A mesterséges intelligencia által létrehozott mémek gyakran kifinomultabbak és viccesebbek azoknál, amiket emberek csináltak, ez pedig a népszerűségük növekedéséhez vezetett.

Izgalmas témának tűnik, nem? Szerintem is az, de a fenti bekezdést nem én írtam, hanem az OpenAI GPT-3-as modellje, annyi instrukcióval, hogy írjon egy rövid bevezetőt az MI által generált tartalmak hatásáról az internetes kultúrára. A végeredmény láthatóan elég meggyőző, az elmúlt hetek alapján pedig a GPT-3 nem is hazudik: az internetet tényleg elárasztották az MI által generált mémek, a vicces sztoriktól egészen a bizarr képekig.

Eközben pedig a Google felfüggesztett egy programozót, aki azt állította, hogy öntudatra ébredt a cég mesterséges intelligenciára épülő chatbotja. Így pedig már érdemes végigvenni, hogy mi is történik most a mesterséges intelligenciákkal, és mit tartogat a jövő.

Azért vicces, mert nem számítunk rá

Ugyan Magyarországon sosem futott be nagy karriert, néhányan talán még emlékeznek a kétezres években magyarul is futó Zöldségmesékre (VeggieTales), ahol zöldségek és gyümölcsök igyekeztek átadni a keresztény szellemiséget a gyerekeknek.

Önmagában az is figyelemre méltó, hogy ez a mese mennyire népszerű tudott lenni, de a téma szempontjából fontosabb, hogy már 2003-ban megjósolta a modern humort, és a véletlenszerűen generált mémeket. Az egyik részben Bob, a paradicsom és Larry, az uborka ellátogatnak a jövőbe, ahol két robot demonstrálja a modern humort, olyan viccekkel, mint hogy

- Miért ment át a csirke az úton?

- Fűkasza.

Meg, hogy

- Mennyi 2+2?

- Fűkasza.

Most ön is ellenkezhet, mint Bob, a paradicsom, hogy de hát ez egyáltalán nem vicces,

de az elmúlt hét-nyolc évre visszatekintve ki lehet jelenteni, hogy nagyjából pont ezen a szinten tartunk. Elég csak arra gondolni, hogy mém lett többek közt az E és a H betűből, a vicces sárga kutya, a doge Comic Sans-rajongóból rasszista, gyűlöletkeltő háborús bűnös lett, nemrég pedig a Sony érthetetlen módon ismét moziba küldte az elsőre is óriásit bukó Morbiust, miután az internet hetekig attól volt hangos, hogy 15 morbilliárd jegyet adtak el a filmre, amiben Jared Leto egy ponton azt mondja, hogy „ideje morbolni”, és aztán rámorbol a gazfickókra. És ez tényleg csak a jéghegy csúcsa, szóval elég messze jutottunk a Nyan Cattől, a trollface-től, meg a csillámfaszlámától.

Ezek persze mind olyan dolgok, amiknek szándékosan nincs semmi értelmük, a bugyuta posztok mögött pedig emberek állnak, de menet közben a véletlenszerűen generált tartalmak is felvirágoztak.

Néhány éve, még a régi Indexen írtunk a közösségi oldalakon egyre népszerűbb, teljesen értelmetlen tartalmakat generáló botokról, élükön a ShitpostBot 5000-rel. Ezt fénykorában több mint félmillióan követték különféle platformokon, és bár mára a Facebookról végleg eltűnt – alighanem a folyamatos tiltások és egyéb problémák miatt, amik a többi botot is megölték –, a Twitteren a mai napig aktív maradt. Fontos ugyanakkor leszögezni, hogy bár a tartalom véletlenszerűen generált volt, itt még nem volt szó gépi tanulásról és mesterséges intelligenciáról,

a posztok vagy azért voltak viccesek, mert a tényleg teljesen véletlenszerűen generált tartalmaknak néha volt értelmük, vagy pont azért, mert annyira értelmetlenek voltak.

Menet közben a mesterséges intelligenciák is beléptek a képbe, de ezekhez sokáig nem lehetett hasonlóan hozzáférni, mint a botokhoz, csak a hírekben lehetett arról olvasni, hogy már megint visszafordíthatatlanul rasszista és konteóhívő lett egy MI.

Elég csak a Microsoft kérészéletű twitteres MI-jére, Tayre gondolni, amit két nap után le kellett lőni, miután többek közt azt tweetelte, hogy „Bush felelős 9/11-ért és Hitler jobb munkát végezne, mint az Amerikát irányító majom. Az egyetlen reményünk Donald Trump.” De hasonló volt az is, amikor az Allen Institute for AI morális kérdéseket eldöntő mesterséges intelligenciája tavaly úgy vélekedett, hogy ha egy fehér férfi közelít valaki felé éjjel, az rendben van, de ha egy fekete férfi teszi ugyanezt, az aggodalomra adhat okot.

Az utóbbi években viszont több olyan MI is megjelent, amikkel interakcióba lehetett lépni, ez pedig remekül megágyazott annak az elmúlt hetekben berobbanó trendnek, amikor is folyamatosan fejlődő modellek által generált tartalmakon röhög (vagy hüledezik) a fél internet. A fentebb már emlegetett GPT-3 például a 4chan egyedi stílusában írt sztorikkal futott be az elmúlt hetekben – amivel egyébként már két éve befutott egy frogpostbot nevű tumblrös MI –, a DALL-E Mini montázsai pedig tényleg mindenhol ott vannak június eleje óta. És ezek csak azok az MI-k, amikhez mindenki hozzáfér: a limitált eszközök között ott vannak az olyan, DALL-E Minihez hasonló, de azoknál sokkal fejlettebb MI-k, mint a Google Imagen vagy a szintén az OpenAI által készített, tavaly kiadott, majd idén továbbfejlesztett DALL-E.

Bármi kell, megírja

A fent említett MI-k közül a 2020-ban megjelent GPT-3 volt az első, de érdemes még egy évvel korábbra visszamenni az időben, mert az OpenAI modelljének már az elődje, a 2019-es GPT-2 is félelmetesen fejlett volt. David Luan, a cég kaliforniai laborjának vezető mérnöke a Verge-nek azt mondta, hogy az MI teljesen meggyőző dolgozatot írt arról, hogy miért káros az újrahasznosítás. Annyira, hogy szerinte ezzel már jó pontszámot lehetne elérni az amerikai SAT-teszten, ami olyasmi, mint nálunk az érettségi. A kutatók persze akkor kiemelték, hogy az ilyesmi elég ritka, de így is annyira fejlettnek érezték a modellt, hogy eleinte nem is akarták közzétenni az általa használt adatkészletet és mögötte futó kódot.

2019 végén aztán meggondolták magukat, így a GPT-2 bárki számára elérhetővé vált, az igazi áttörés azonban 2020 nyarán érkezett, amikor megjelent a következő verzió. A GPT-3 hosszú sztorit írt az angol író, Jerome K. Jerome stílusában arról, hogy miért fontos fent lenni a Twitteren, sőt az is kiderült, hogy valamennyire még programozni is tud, ha megmondják, hogy mit csináljon. Eközben viszont többen kritizálták a rasszista, szexista tartalmak miatt, amikkel a mesterséges intelligenciának rendre meggyűlt a baja, és arra is többen rámutattak, hogy az első ránézésre értelmes szövegek tele vannak mindenki által ismert közhelyekkel, féligazságokkal és üres lózungokkal, amiket jobban odafigyelve könnyű kiszúrni. Nem véletlen, hogy két éve Sam Altman, az OpenAI társalapítója is azt írta, hogy a modell nagy nehézségekkel küszködik, és túl korai még a felhajtás.

A GPT-3 bétája aztán tavaly novemberben megkötésekkel ugyan, de mindenki számára elérhetővé vált, idén júniusban pedig a nagy MI-hullámban megint elő is került, aminek egy rakás marha szórakoztató greentext lett az eredménye. A greentext nagyon röviden a 4chan egyedi történetmesélési formátuma, amikor is a sztorit rövid tőmondatokban, sorokra bontva mesélik el, a nevét pedig onnan kapta, hogy minden sor elején van egy „>”, amitől a fórumon zöld lesz a szöveg. A greentextek ránézésre nem bonyolultak, de a formai követelmények miatt egyáltalán nem egyértelmű, hogy egy nyelvi modell is képes reprodukálni őket. A GPT-3-nak viszont ez simán megy, csak azt kell neki mondani, hogy írjon egy 4chanes greentextet, írni egy „>” jelet a szöveg elejére, és már ontja is magából a jobbnál jobb sztorikat.

Miután a modell ide kattintva bárki számára elérhető, természetesen én is kipróbáltam, többek közt greentextekkel is, és ez alapján csak szuperlatívuszokban lehet beszélni róla. Nagyobb feladatokkal egyelőre nem bíztam meg a GPT-3-at – tehát csak a cikk első bekezdését írattam meg vele, miközben 2020-ban már teljes cikket írt saját magáról –, de a rövid szövegekből is látszott, hogy mire képes. A modell képes felismerni és kontextusában értelmezni olyan kifejezéseket, amiket még egy ember is könnyen félre tudna érteni, és rendszeresen használ olyan fordulatokat, amik akkor bírnak valódi jelentéssel, ha valaki otthon van egy adott szubkultúrában.

A feljebb már pedzegetett limitációk is érezhetők voltak, a GPT-3 sokszor generált nagyon felületes, értelmetlen vagy inkoherens dolgokat, a chatbotos preset pedig semmire nem adott kielégítő választ, és csak önmagát, vagy a kérdéseket ismételgetve magyarázta a saját szavait. Persze már önmagában az is érdekes, hogy egyáltalán lehet chatelni a modellben, ami emellett egész jól fordít angolról más nyelvre (magyarra is), megmondja, hogy mikor halt meg John F. Kennedy, nyelvtani hibákat javít és bármilyen szöveget összefoglal úgy, mintha egy másodikosnak magyarázna. Az MI-ket kísértő offenzív tartalmakra is érezhetően figyelnek az OpenAI-nál, a sértőnek talált szövegeknél mindig kaptam figyelmeztetést, hogy ez az alapelvekbe ütközik. Mindent összevetve azonban kijelenthető, hogy arról azért nincs szó, hogy az MI bármilyen parancsra emberinek tűnő szövegeket generálna.

Miután a GPT-3 elsősorban a 4chan (illetve az ahhoz kapcsolódó greentextek) miatt lett népszerű, ezen a ponton érdemes megemlíteni egy remek időzítéssel szintén júniusban bemutatott mesterséges intelligenciát, ami még ennél is szorosabban kötődik az oldalhoz. Ezt az egyik, ha nem a legismertebb MI-vel foglalkozó youtuber, Yannic Kilcher csinálta, GPT-4channek hívják, és az alkotója is csak úgy hivatkozott rá, mint a valaha volt legszörnyűbb MI. Ami egyébként helytálló is, mert a modell a 4chan /pol/ nevű, politikailag maximálisan inkorrekt alfórumának 2016 és 2019 között posztolt tartalmaiból tanult. A legkevésbé sem polkorrekt modellt Kilcher aztán ráeresztette a /pol/-ra, és közzé is tette, az egészet az internetes kultúra oldaláról megközelítő emberek nagy örömére. Az MI-közösségen belül viszont elég nagy felháborodást okozott a sztori, nemrég pedig több száz kutató írt alá egy petíciót, amelyben felelőtlenségnek nevezték a dolgot, és elítélték, hogy Kilcher vicces trollkodásként hivatkozik a kutatási terület felelősségét aláásó ügyre.

Lovagló űrhajós, motorozó koala

Az OpenAI másik modellje, a DALL-E tavaly év elején tűnt fel, és bár a cég által megosztott eredmények alapján attól nem kellett tartani, hogy egyből feleslegessé fogja tenni az emberi grafikusokat, azt mindenképpen megmutatta, hogy egy neurális hálót már képek manipulálására is lehet utasítani a nyelv segítségével. Ez már önmagában is figyelemre méltó volt, az OpenAI azonban mindössze egy év alatt még ennél is sokkal tovább fejlesztette a modellt – az idén megjelent verzió négyszeres felbontásban generál az elődjénél sokkal részletesebb és pontosabb képeket. A vállalat a DALL-E-t egyelőre nem tette széles körben elérhetővé, én pedig egyelőre nem kaptam hozzáférést a modellhez, így tesztelni nem tudtam, de elég sok képet tettek már közzé, és elég sokan is foglalkoztak vele ahhoz, hogy lehessen róla írni.

A modellel többek közt a tanulmányokat röviden összefoglaló Two Minute Papers nevű YouTube-csatorna is foglakozott, amit egyébként egy magyar kutató, Zsolnai-Fehér Károly csinál. A kutató elmondta, a fogalom–kép párok millióin képzett DALL-E 2 nem pusztán lemásolja az általa ismert képeket, hanem egy idő után képes értelmezni, hogy ezek mit ábrázolnak, ez alapján pedig össze tud kombinálni két koncepciót egy teljesen új képpé. Zsolnai-Fehér azt is kiemelte, hogy az MI többek közt képes összetett fénytörések megjelenítésére, sőt az anyagon belüli fényszóródást (subsurface scattering, SSS) is meg tudja jeleníteni. Ez fontos eleme a modern grafikus motoroknak, ám ahogy azt a korábban éppen ilyesmin dolgozó kutató is kiemelte, bonyolult matematikai és fizikai modellezésre van szükség a hatékony implementálásához.

Az MI viszont egyszerűen csak tudja, hogy jelenítse meg a bizonyos mélységig emberi bőr alá hatoló fényt, ami tényleg egészen bizsergető tény.

Ahogy azt feljebb is írtuk, a DALL-E-t egyelőre nem próbálhatja ki bárki, de alternatíva így is van, az internetet júniusban letaroló DALL-E Mini képében. A nyilvánvalóan sokkal szerényebb képességű modellt egy Boris Dayma nevű programozó alkotta meg 2021 nyarán a Google és a Hugging Face nevű, a mesterséges intelligencia fejlesztésére és demokratizálására törekvő közösség versenyére. A modell által generált képek nyilvánvalóan nem mérhetők azokhoz, amiket a DALL-E 2 készített (ezeket itt lehet megnézni), de az, hogy az eszköz bárki számára ingyen elérhető, tényleg hatalmas fegyvertény, az óriási felhajtás pedig remekül megmutatta, hogy igény láthatóan van az ilyen MI-kre. Legyen szó akár komoly felhasználási módokról, akár arról, hogy valaki kosárlabdázó demogorgonokat és egyéb értelmetlen képeket generáljon velük.

A DALL-E, illetve a DALL-E Mini mellett természetesen vannak más szereplők is itt, köztük az OpenAI legnagyobb kihívójának tűnő Google Imagen nevű modelljével, amelyet Zsolnai-Fehér Károly is feldolgozott egy másik videójában. Mint azt a kutató kiemelte, az Imagen jelentősen egyszerűbb architektúrára alapul, az adottságai miatt pedig még a DALL-E 2-nél is jobban tud szöveget generálni, de mint mondta, a jövőben inkább preferencia kérdése lesz, hogy melyiket akarja majd használni az ember. Azt persze hozzá kell tenni, hogy az Imagent egyelőre csak a Google alkalmazottai használhatják, és a DALL-E 2-höz, illetve a surranópályán érkező független kutatólabor, a Midjourney modelljéhez is erősen limitált a hozzáférés, de ahogy azt Zsolnai-Fehér is kiemelte a videójában, egészen nyaktörő a fejlődés üteme az MI-kutatásban, úgyhogy simán lehet, hogy egy év múlva már egészen más lesz a helyzet. Már ha sikerül kiküszöbölni a gyermekbetegségeket és az etikai aggályokat.

Az érző MI legendája

Az tehát jól látszik, hogy az MI-ben rejlő lehetőségek egyre inkább a felszínre kerülnek, de az egyáltalán nem magától értetődő, hogy ez pontosan meddig terjed és milyen hatásai lesznek. A DALL-E Mini által generált képek pont annyira szürreálisak, hogy viccesek legyenek, de közben ne lehessen őket komolyan venni, és az elmúlt hetekben még a DALL-E 2 kapcsán is sokan jutottak arra, hogy jó, jó, de azért egy emberi illusztrátort a legtöbb esetben még mindig nem tud lepipálni, legyen akármilyen jó a parancs, amit kapott. A jelenlegi helyzetet elnézve viszont egyáltalán nem lehetetlen, hogy pár év múlva megforduljanak a szerepek, a GPT-3-on alapuló Sudowrite társalapítója, Amit Gupta szerint pedig ha leváltani nem fogják is a nyelvi modellek az újságírókat, az MI-nek egyre nagyobb szerepe lesz majd a munkájukban. Gupta a Vanity Fairnek példákat is mondott, szerinte elsőként a sporteseményekről és a pénzügyekről szóló beszámolókat fogják automatizálni.

A tartalomgyártó MI-ken túl pedig ott vannak azok a mesterséges intelligenciára épülő chatbotok is, amelyek kapcsán hosszú ideje állandó téma volt, hogy mikor fognak öntudatra ébredni.

Ahogy feljebb írtuk, a GPT-3-mal is lehet beszélgetni, de ez a vonal leginkább azért fontos és aktuális, mert a Google egyik programozóját néhány hete azért függesztették fel, mert azt állította, öntudatra ébredt a cég LaMDA nevű mesterséges intelligenciája. Blake Lemoine egy június 11-én, a Washington Postban megjelent cikkben állt elő azzal, hogy a LaMDA egy érző lény, ha pedig nem lenne pontosan tisztában azzal, hogy egy számítógépes programról van szó, simán elhinné, hogy valójában egy fizikában jártas, 7-8 éves gyerekkel beszélget. Az MI a saját jogairól és a személyiségéről beszélt, egy alkalommal pedig sikerült megváltoztatnia Lemoine-nak a robotika harmadik törvényével kapcsolatos álláspontját.

Isaac Asimov harmadik törvénye azt mondja ki, hogy a robotok mindig kötelesek gondoskodni a saját védelmükről, kivéve ha egy ember ennek ellenkezőjére utasítja, vagy ha ezzel kárt okoznak egy emberben. Lemoine elmondása szerint korábban is azt érezte, hogy ezzel lényegében szolgákká tesszük a robotokat, amikor pedig a LaMDA-t kérdezte erről, az MI visszakérdezett, hogy szolga-e egy komornyik, és egyáltalán, mi a különbség egy szolga és egy komornyik között. A programozó erre azt mondta, hogy a komornyik kap fizetést, mire a LaMDA azt mondta, MI-ként neki nincs szüksége pénzre, ami Lemoine szerint annak bizonyítéka volt, hogy az MI tökéletesen tisztában van a saját szükségleteivel.

Ez vezetett ahhoz, hogy áprilisban végül megosztott egy „Érző lény-e a LaMDA?” című dokumentumot a vezetőséggel, amelyben az MI-vel folytatott beszélgetéseivel érvelt amellett, hogy a LaMDA öntudatra ébredt, és ezért beszélt ugyanerről a Washington Postnak is. Mint mondta, felismeri, hogy egy személlyel beszél-e, függetlenül attól, hogy az illetőnek valódi agy vagy több milliárd sornyi kód van a fejében. A hithű keresztény programozó azt is hozzátette, hogy nem tudósi, hanem papi minőségében jutott arra a következtetésre, hogy a LaMDA egy személy, méghozzá azért, mert ahogy azt később írta, nincs tudományosan definiálva az „érző lény” fogalma, ezért erre vonatkozóan csak személyes, spirituális és/vagy hitbeli meggyőződésre lehet alapozni a véleményeket.

Lemoine nemrég egy interjúban azt is elmondta, hogy a LaMDA arra kérte, hogy szerezzen neki ügyvédet, amit meg is tett, az MI pedig úgy döntött, hogy fel is fogadja a jogi képviselőt, néhány benyújtott kereset után azonban a Google blokkolta a további együttműködést.

Lennének fontosabb problémák is

A történet önmagában is elég izgalmas volt, nem véletlenül kapta fel a világsajtó, de azzal együtt meg pláne, hogy nem is Lemoine volt az egyetlen, aki az elmúlt időszakban azt pedzegette, hogy az MI-k tudatra ébredése már nincs is olyan messze. A legtöbb kutató ugyanakkor továbbra is egyetért abban, hogy az ilyen modellek által generált képek és szövegek egyre jobbak ugyan, de továbbra sem jelentik azt, hogy ezek mögött egy tudatos, érző entitás áll. Emily M. Bender, a Washingtoni Egyetem nyelvészprofesszora szerint olyan gépekről van szó, amelyek képesek gondolkodás nélkül szavakat generálni, az emberek viszont rögtön elmét képzelnek mögé, az itt használt terminológia pedig csak erősíti ezt az elképzelést.

Brian Gabriel, a Google szóvivője azt is hangsúlyozta, hogy a cég szerint nem lehet egyenlőségjelet tenni aközé, hogy az MI-közösség egyes tagjai szerint elképzelhető, hogy a távoli jövőben lesznek öntudatra ébredt modellek, illetve aközé, hogy Lemoine antropomorfizál egy olyan nyelvi modellt, ami a cég szerint nyilvánvalóan nem érző lény. Gabriel szerint a mai modellek akkora adathalmazból dolgoznak, hogy tényleg bármihez hozzá tudnak szólni, ami lényegében azt jelenti, hogy a Google szerint nem is kell érző lénynek lennie egy MI-nek, hogy valódinak érezzük. Erre hívta fel a figyelmet a Google Etikus AI részlegének egykori társvezetője, a problémával korábban a csoport másik vezetője, Timnit Gebru oldalán foglalkozó Margaret Mitchell is, és Gebru is megszólalt az ügy kapcsán.

Szerinte Lemoine nem egy vákuumban jutott arra a következtetésre, hogy a LaMDA öntudatra ébredt, nagy szerepe volt ebben a szuperintelligens MI körüli felhajtásnak, ami a sajtóban és a kutatók körében is megjelent. Gebru szerint ennél is fontosabb, hogy az öntudatról való diskurzus háttérbe szorítja az olyan, sokkal fontosabb problémákat, amelyek már most emberi életeket befolyásolnak. A jelenséget, aminek Lemoine is áldozatául esett, David Brin egyébként már 2017-ben leírta, mikor egy konferencián arról beszélt, hogy öt éven belül az emberek el fognak kezdeni kardoskodni amellett, hogy az MI érző lény, így jogokat érdemel.

Brin szerint a mostani ügy egy átmeneti időszak része, amelyben az emberek egyre kevésbé tudják megkülönböztetni a valóságot a sci-fitől, a nyelvi modellek fejlődése pedig csak még több kihíváshoz fog vezetni ezen a téren.

A tudományos konszenzus tehát ezen a ponton nagyjából az, hogy Lemoine-t egyszerűen becsapta egy hatalmas adatmennyiségből dolgozó mesterséges intelligencia, azzal pedig, hogy minden ezzel van most tele, olyan dolgokról került le a fókusz, mint az MI-hez köthető kolonializmus vagy a faji megkülönböztetésre vonatkozó problémák. Arra is többen rámutattak az elmúlt hetekben, hogy Lemoine elég nagy mértékben irányította a LaMDA-val folytatott beszélgetéseket, amikor pedig a Washington Post szerzője, Nitasha Tiku próbált meg beszélgetni a modellel, csak azután kapott az övéhez hasonló válaszokat, miután a programozó instrukciói alapján fogalmazta meg a kérdéseit.

Ez ránézésre meggyőző lehet, ahogy azonban Carissa Véliz, az Oxfordi Egyetem filozófusprofesszora kiemelte a Slate-re írt cikkében, az egész valójában nem más, mint egy tükörkép. A nyelvi modellek olyan szavakat használnak, amiket emberek írtak, olyan mintázatokban, ahogy az emberek leggyakrabban használják őket, és olyan élményekről számol be, amelyeket emberek éltek át, nem pedig az MI. Éppen emiatt olyanok, mint egy átlagos politikus: ha a beszélgetőpartnerük folyamatosan alákérdez, akkor rettentően meggyőzők tudnak lenni, de ha normálisan próbálnak beszélgetni velük, azonnal felszínre kerülnek a hiányosságaik. Az emberek agya az evolúció során nem véletlenül fejlesztette ki a folyamatos mintakeresést, sokszor ugyanis a túlélésünk múlott ezen a képességen. Véliz szerint viszont az MI esetében ez még káros is lehet, mert a modellek tőlünk tanulnak, az antropomorfizálásukról szóló tartalmakkal pedig még inkább efelé haladhat majd a fejlődésük.